プロンプトエンジニアリングの概要

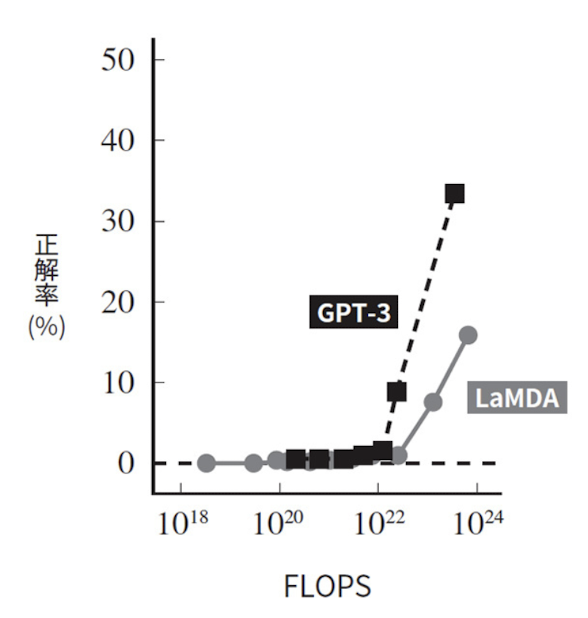

“BERTの概要とアルゴリズム及び実装例について“で述べているBERTではパラメター数が3.5億、コーパスに含まれる単語数が30億、”GPTの概要とアルゴリズム及び実装例について“で述べているGPTの発展系であるGPT2のパラメータ数は15億、コーパス数は100-200億だったのに対して、近年のモデルであるGPT3では1750億パラメータ、コーパス数は3000億となり、モデルが大幅に増加している。このような大規模化により性能が急激に改善し、

これまでファインチューニングを個別に行わなければ解けないと思われていた多くのタスクが、モデルにプロンプトと呼ばれるテキストを入力して後続するテキストを予測するという単純な方法で解けるようになってきた。

「プロンプトエンジニアリング(Prompt Engineering)」は、自然言語処理や機械学習モデルの開発において、与えられたテキストプロンプト(指示文)を工夫し、特定のタスクや目的に最適な応答を引き出す技術や手法を指す。これは、OpenAIの”GPTの概要とアルゴリズム及び実装例について“でも述べているGPT(Generative Pre-trained Transformer)などの大規模な言語モデルを使用する場合に特に有用なアプローチとなってきた。

プロンプトエンジニアリングの基本的な考え方は、モデルに対して適切な質問や指示を与えることで、より良い結果を得るという点にある。プロンプトはモデルへの入力として機能し、その選択や表現はモデルの出力に影響を与える。

以下は、プロンプトエンジニアリングの一般的な手法や考慮事項となる。

1. 具体性と明確さ: プロンプトは具体的で明確な指示を含むように設計されるべきであり、模糊な表現や抽象的な指示では、モデルが望ましい結果を生成するのが難しくなる。

2. モデルの理解と適応: 特定のモデルがどのような種類のプロンプトに対して得意であるかを理解し、そのモデルに適した形式のプロンプトを設計する。

3. モデルの弱点の補強: モデルが特定のトピックや文脈で誤った情報を生成しやすい場合、プロンプトを工夫してこれらの弱点を補強することが求められる。

4. 反復的な実験: 積極的な実験や試行錯誤を通じて、どのようなプロンプトが望ましい結果を引き出すかを探求する。プロンプトの調整は反復的なプロセスであり、実際の使用例からのフィードバックを受け入れることが重要となる。

5. ドメイン特有の知識の活用: 特定のドメインにおいては、そのドメインに関する専門知識をプロンプトに組み込むことが役立つ。

6. 倫理的な考慮: プロンプトの設計においては、倫理的な観点から不適切な内容やバイアスを含まないように留意する必要がある。

プロンプトエンジニアリングの種類について

プロンプトエンジニアリングの種類は、適用されるコンテキストや目的によって異なる。以下に、一般的なプロンプトエンジニアリングの種類について述べる。

1. ファインチューニングプロンプト: 既存のモデルを特定のタスクに向けて微調整する場合に使われる。ファインチューニングプロンプトは、モデルに特定の入力を与え、特定の出力を引き出すように設計され、例えば、感情分析タスクの場合、「この文章の感情を判定してください」といったプロンプトを利用するものとなる。

2. バイアスの補正プロンプト: モデルがバイアスを持ってしまう場合、バイアスの補正を目的としたプロンプトが使用される。これは、公平性や偏りの問題に対処するための手法であり、例えば、性別や人種に関するバイアスを補正するためのプロンプトを導入する。

3. 生成タスク向けプロンプト: テキスト生成タスクにおいて、特定の内容や形式の文章を生成するようにプロンプトを設計する。これは例えば、対話型の文章生成の場合、「2人のキャラクターが対話してください」といったプロンプトを使うようなものとなる。

4. 文脈の制御プロンプト: モデルに対して特定の文脈や情報を与え、それを考慮した生成結果を引き出すためのプロンプトで、例えば、前の文章の内容を考慮して次の文章を生成するような文脈制御が行われる。例を一つ与える場合をone-shot学習、複数与える場合をfew-shot学習、まったく与えない場合をzero-shot学習と呼ぶ。文脈学習は、学習を行う方法そのものを学習するため”Few-shot/Zero-shot Learningにも活用可能なMeta-Learnersの概要と実装例“や”Meta-Learnersを用いた因果推論の概要とアルゴリズム及び実装例“でも述べているメタ学習の一種であるとも考えられている。

5. 対話型プロンプト: モデルに対して対話的なやり取りを促すためのプロンプト。これにより、対話が進む中でモデルの出力を調整することが可能になる。

6. モデル理解プロンプト: モデルが特定の概念やドメインについて理解するためのプロンプト。これにより、モデルが特定のトピックに関する質問に適切に答える能力を向上させることができる。

7. chain-of-thought推論プロンプト: 大規模言語モデルが苦手とされるタスクの一つに多段階の推論が必要となるマルチステップ推論がある。これは例えば「部屋に23個のりんごがありました。料理に20個を使い、6個を買い足した時に、何個のりんごが残りますか」という問題は23-20=3個のりんごが残って、その後買い足して3+6=9個のりんごが残るというように2段階で推論を行うものとなる。このような場合に適用させるために、推論過程の例を与えたり、推論過程の生成を促す「ステップごとに考えよう」のような文字列をプロンプトの末尾に付加する方法が考えられている(zero-shot chain-of-thought推論)。

その他のプロンプトエンジニアリングの手法に関しては”Prompt Engineering Guide“を参照のこと。

プロンプトエンジニアリングに用いられるライブラリやプラットフォームについて

プロンプトエンジニアリングにおいて、特に大規模な言語モデルを使用する際には、そのモデルを操作し、プロンプトを設計するためのライブラリやプラットフォームが利用される。以下は、プロンプトエンジニアリングに用いられるいくつかのライブラリやプラットフォームについて述べる。

OpenAIのGPT-3はプロンプトエンジニアリングに広く使用されているツールとなる。OpenAIはGPT-3を利用するためのAPIを提供しており、OpenAI GPT-3 Playgroundを通じて直接利用できる。Playgroundは対話型で、様々なプロンプトを試すことが可能となる。Open AIのAPI利用に関しては”ChatGPTとLangChainの概要及びその利用について“も参照のこと。

2. Hugging Face :

Hugging Faceは、自然言語処理のモデルに関するライブラリやプラットフォームを提供している。Transformersライブラリは、様々なプリトレーニング済みモデル(例: GPT-2, GPT-3, BERTなど)にアクセスし、これを用いてプロンプトエンジニアリングを行うことが可能となる。Hugging Faceに関しては”Huggingfaceを使った文自動生成の概要“も参照のこと。

3. OpenAI Codex (GitHub Copilot):

OpenAI Codexは、GitHub Copilotとしても知られている。CodexはGPTモデルを基にしており、プログラミングにおいてもプロンプトエンジニアリングを利用できるものとなる。これはコードの生成において特に有用であり、コード補完や生成のプロンプト設計が行えるツールとなる。詳細は”OpenAI Codexの概要とその利用について“も参照のこと。

4. DeepPrompt:

DeepPromptは、プロンプトエンジニアリングに特化したプラットフォームとなる。DeepPromptを使用すると、異なるタスクやドメインにおいてモデルへのプロンプトを簡単に設計できる。詳細は”DeepPromptの概要とその利用について“を参照のこと。

5. LangChain:

LangChainは、言語モデルを使ったアプリケーションを開発するのを助けるライブラリであり、ChatGPTやその他の生成モデルを使った様々なアプリケーションを構築することが可能なプラットフォームとなる。LangChainの詳細に関しては”ChatGPTとLangChainの概要及びその利用について“も参照のこと。

プロンプトエンジニアリングの適用事例について

以下にいくつかのプロンプトエンジニアリングの適用事例を示す。

1. 質問応答システム:

医療相談:医療専門家や患者が症状について質問し、モデルが適切なアドバイスや診断を提供するためのプロンプトを設計する。

一般知識の質問応答:利用者があらゆるトピックについて質問し、モデルが適切な回答を提供するためのプロンプトを設計する。

2. コンテンツ生成:

文章作成支援:特定のトピックについて記事やレポートを生成する際に、モデルが特定の視点やスタイルで文章を生成するようにプロンプトを設計する。

詩や小説の生成:詩や小説の特定のシーンやテーマに基づいて、モデルが続きを生成するようにプロンプトを設計する。

3. コンピュータプログラムの生成:

コード補完:プログラマーが特定の機能やアルゴリズムに基づいてコードを書く際に、モデルが適切なコードの断片を生成するようにプロンプトを設計する。

ゲームのAI生成:ゲーム開発者が、特定の挙動やタスクを持つゲームのAIを生成するためのプロンプトを設計する。

4. クリエイティブコンテンツ生成:

画像生成:画像キャプション生成、画像スタイルの変更、画像の特定の部分の生成など、画像処理タスクに応じたプロンプトを設計する。

音楽やメロディの生成:特定のジャンルや気分に基づいて音楽を生成するためのプロンプトを設計する。

これらは一部の例であり、プロンプトエンジニアリングはさまざまな領域で応用が可能であり、適切なプロンプトを設計することで、モデルが特定のタスクに適した出力を生成できる。

プロンプトエンジニアリングの実装例について

プロンプトエンジニアリングの実装例として、Hugging FaceのTransformersライブラリを使用したGPT-3のプロンプト設計を示す。この例では、Hugging Face Transformersを使ってGPT-3に対してプロンプトを提供し、望む形式の応答を引き出す方法について述べている。

まず、Transformersライブラリをインストールする。

pip install transformers次に、以下のPythonコードを利用してGPT-3に対してプロンプトを提供する例を示す。

from transformers import GPT2LMHeadModel, GPT2Tokenizer

def generate_prompt_response(prompt):

# GPT-3モデルとトークナイザの読み込み

model = GPT2LMHeadModel.from_pretrained("gpt2")

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

# プロンプトをトークン化

input_ids = tokenizer.encode(prompt, return_tensors="pt")

# GPT-3に対してプロンプトを提供して生成結果を得る

output = model.generate(input_ids, max_length=100, num_beams=5, no_repeat_ngram_size=2, top_k=50, top_p=0.95, temperature=0.7)

# 生成されたトークンをデコードしてテキストに変換

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

return generated_text

# 例: プロンプトを設計してGPT-3に提供し、生成されたテキストを取得

prompt_example = "Translate the following English text to French: 'Hello, how are you?'"

response_example = generate_prompt_response(prompt_example)

print("Input Prompt:")

print(prompt_example)

print("\nGenerated Response:")

print(response_example)この例では、英語のテキストをフランス語に翻訳するプロンプトを設計し、GPT-3に提供して生成された応答を取得している。プロンプトエンジニアリングのポイントは、プロンプトの具体性や明確さ、モデルの理解と適応、さらに適切なパラメータ調整にあり、プロンプトに対する微調整や実験を通じて、望む形式の結果を得るために調整が行われる。

プロンプトエンジニアリングの課題と対応策について

以下にプロンプトエンジニアリングの課題とその対応策について述べる。

1. バイアスと倫理の問題:

課題: 訓練データやプロンプトの設計において、バイアスや偏りが生じる可能性がある。これにより、モデルの出力に不適切なバイアスが反映されることがある。

対応策: プロンプトの設計において注意深く言葉を選び、公平性や倫理に配慮したプロンプトを作成することが重要となる。また、生成結果の評価には多様な視点を取り入れることが役立つ。

2. 未知のプロンプトへの対応:

課題: モデルは訓練データに基づいており、未知のプロンプトに対して不適切な応答を生成する可能性がある。

対応策: プロンプトのバリエーションを増やし、未知の状況にも対応できるように訓練データやプロンプトを多様化させることが有用なアプローチとなる。

3. 適切なプロンプトの見つけにくさ:

課題: どのプロンプトが最適かを見つけるのが難しい場合があり、特に大規模なモデルでは、適切なプロンプトの設計が難しい。

対応策: 反復的な実験や試行錯誤を通じて、最適なプロンプトを見つけるためのプロセスを構築する。ユーザーフィードバックやモデルの性能評価を活用して、プロンプトを調整することも有用となる。

4. 生成結果の不確実性:

課題: モデルが生成した結果には確信度の差があり、不確実性が含まれることがある。

対応策: ユーザーに対して不確実性を伝える手段を導入し、適切な場面でユーザーが検討できるようにする。また、確率的な生成により複数のサンプルを得て、そのバリエーションを考慮することも重要となる。

5. プロンプトの依存性:

課題: プロンプトの微調整がモデルの性能に大きな影響を与える可能性があり、特定のプロンプトに過度に依存することが課題となる。

対応策: 複数のプロンプトを試し、モデルの性能がプロンプトに強く依存しないように工夫する。さらに、モデルの改善がプロンプトに依存しないよう、モデルのトレーニングデータや設計にも注意を払うことも重要となる。

参考情報と参考図書

機械学習による自動生成に関しては”機械学習による自動生成“に詳細を述べている。そちらも参照のこと。

参考図書としては“機械学習エンジニアのためのTransformer ―最先端の自然言語処理ライブラリによるモデル開発“

“

“

コメント

[…] プロンプトエンジニアリングの概要とその利用について […]

[…] これらの機能を用いることで”プロンプトエンジニアリングの概要とその利用について“で述べているプロンプトエンジニアリング(自然言語処理や機械学習モデルの開発において […]