Stable Diffusionの概要

Stable Diffusionは、機械学習と生成モデルの分野で使われる手法の1つであり、画像や音声などの生成モデルとして知られる”Diffusion Models(拡散モデル)の概要とアルゴリズム及び実装例について“で述べているDiffusion Modelsの拡張となる。Diffusion Modelsは、画像の生成や修復において高い性能を示すことが知られており、Stable Diffusionは、これをさらに発展させ、より高品質で安定した生成を可能にする。

特徴:

1. 高品質な生成: Stable Diffusionは、画像や音声などの生成において、非常に高品質な結果を生み出すことができる。これは、高解像度の画像や自然な音声の生成にも適している。

2. 安定した学習: 通常、生成モデルは学習が安定しづらいという課題があるが、Stable Diffusionはその名の通り、安定した学習が可能なものであり、これにより、より短い時間で高品質なモデルを学習することができる。

3. 階層的生成: Stable Diffusionは、画像や音声などの生成を階層的に行うことができ、これは、より複雑な構造を持つデータの生成に適している。

4. 高い柔軟性: さまざまなデータ形式に対応できる柔軟性があり、画像、音声、テキストなど、さまざまな種類のデータ生成に利用できる。

Stable Diffusionに関連するアルゴリズム

以下に、Stable Diffusionアルゴリズムの概要を示す。

1. Diffusion Process (拡散過程): 最初のステップでは、入力画像が徐々にノイズで汚染されていく「拡散過程」が開始される。これは、生成したい画像の初期化段階と考えることができる。

2. Sampling (サンプリング): 拡散過程の各ステップで、ノイズが徐々に増加していく中で、一部のピクセルをサンプリングする。このサンプリングされたピクセルは、次のステップで復元されるための情報源となる。

3. Restoration (復元): サンプリングされたピクセルに基づいて、画像が再構築される。これは、拡散過程の反対方向に進むことで行われ、復元プロセスでは、サンプリングされたピクセルを中心に周囲のピクセルが推定される。

4. Reconstruction (再構築): 拡散過程と復元プロセスの結果を組み合わせて、最終的な生成画像が構築される。この段階では、復元されたピクセルと元の画像の情報が組み合わされ、最終的な出力が生成される。

Stable Diffusionの適用事例

Stable Diffusionは、画像生成、画像修復、画像編集などの様々な分野で幅広く適用されている。以下にそれら適用事例について述べる。

1. 画像生成 (Image Generation): Stable Diffusionは、”GANの概要と様々な応用および実装例について“でも述べているGAN(Generative Adversarial Networks)と比較して、より安定して高品質な画像生成を提供することが知られている。自然な画像の生成、特に高解像度の画像生成に有用で、これは、芸術的な創造活動やデザイン業界での利用に適している。

2. 画像修復 (Image Restoration): 損傷した画像の修復や欠損部分の補完にもStable Diffusionが活用されている。例えば、古い写真の修復、画像のノイズ除去、欠損した部分の補完などが挙げられ、Stable Diffusionは、修復された画像が自然な見た目を保ちながら、損傷やノイズを効果的に除去することができる。

3. 画像編集 (Image Editing): 画像の特定の部分を編集する際にもStable Diffusionが利用される。例えば、顔や背景の修正、不要なオブジェクトの除去、画像のスタイル変換などがあり、Stable Diffusionを用いることで、編集された画像が自然な見た目を保ちながら、目的に応じた変更を施すことができる。

4. ドメイン適応 (Domain Adaptation): Stable Diffusionは、異なるドメイン間での画像変換やドメイン適応にも使用されている。例えば、日中の画像から夜間の画像への変換、写真からアートスタイルへの変換などがあり、これは、自動運転技術やロボティクスなどの領域で、センサーデータの変換や合成が必要な場合に役立つ。

Stable Diffusionの活用と実装

Stable DiffusionはHugging Face、Dream Studio、Mageの3つのwebサービスで利用することができる。

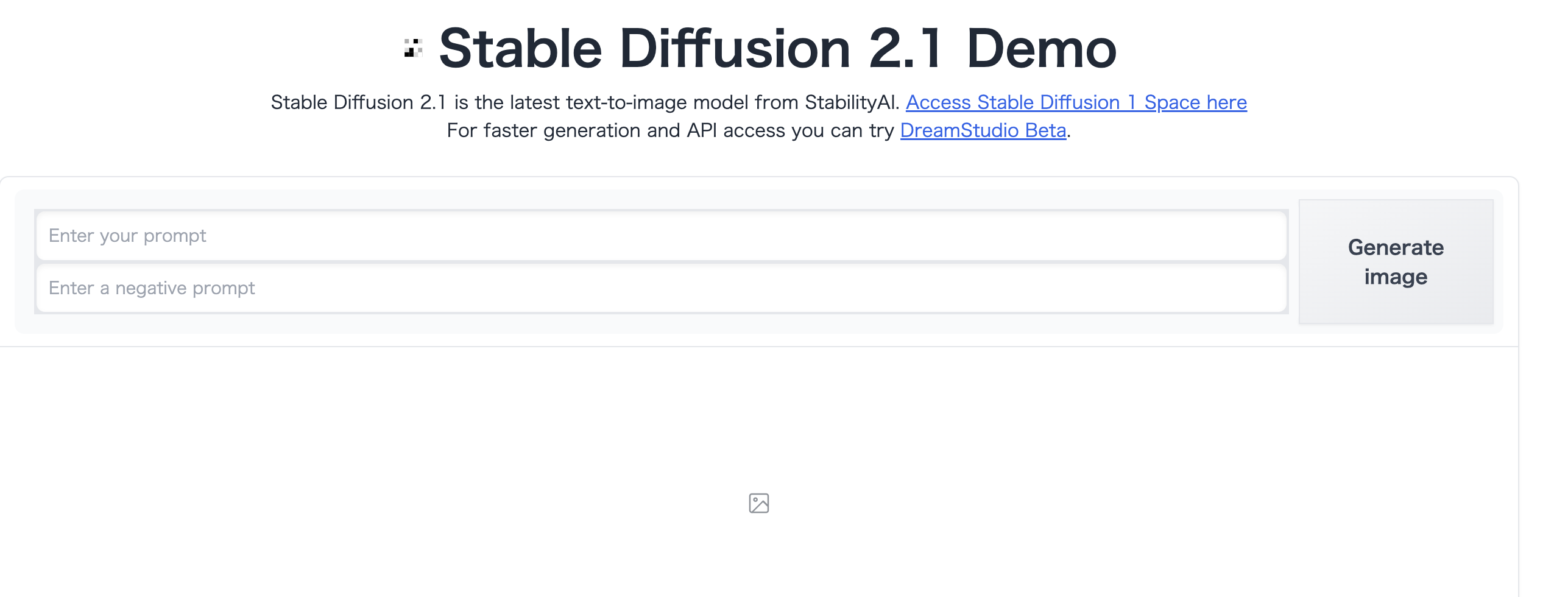

“Huggingfaceを使った文自動生成の概要“で述べているHugging Faceは生成系モデルを集めたレポジトリであり、Stable Diffusionのデモである「Stable Diffusion 2 Demo」も含まれている。

Stable Diffusion 2を利用する操作手順は非常にシンプルで、テキスト入力エリアに生成したい画像を表すテキストを入力し、画像生成実行ボタンをクリックするだけです。生成された画像が表示されるものとなる。

また”text-generation-webuiとAUTOMATIC1111を用いたコードレス生成モジュール“に述べているAUTOMATICのstable-diffusion-webuiをダウンロードしてrunさせることでweb版のstable diffusionをローカルに立ち上げることもできる。

Stable DiffusionのLoRAによるファインチューニングの実装例について

“LoRAによるLLMのファインチューニングの概要と実装例について“でも述べているLoRA を用いることでStable Diffusionのファインチューニングを行うことができる。具体的には、以下の手順に従って、PyTorchを使用してLoRAによるファインチューニングを行う。

- Stable Diffusionモデルの準備: まず、Stable Diffusionの元となるモデルを準備する。このモデルは、生成、修復、編集などのタスクに応じて事前にトレーニングされている必要がある。

- LoRAの準備: 次に、LoRAの実装をPyTorchで準備する。これには、LoRAのネットワークアーキテクチャや学習プロセスなどを含み、LoRAの公式リポジトリや関連する研究論文を参考にすることができる。

- ファインチューニングの設定: ファインチューニングのための設定を行う。この際、Stable Diffusionモデルをロードし、LoRAの最適化手法を適用する。また、ファインチューニングする際のデータセットや学習パラメータなどを設定する。

- ファインチューニングの実行: 上記の設定を基に、Stable DiffusionモデルにLoRAを適用してファインチューニングを行う。トレーニングデータセットを使用して、モデルを反復的に学習させる。

- 評価と結果の解析: ファインチューニングが完了したら、評価データセットを使用してモデルの性能を評価し、結果を解析する。生成された画像の品質や、修復された画像の正確性などを評価する。

以下は、PythonとPyTorchを使用したLoRAによるStable Diffusionのファインチューニングの簡単な実装例となる。

import torch

import torch.optim as optim

from stable_diffusion_model import StableDiffusionModel

from lora_model import LoRAModel

from dataset import CustomDataset

from torch.utils.data import DataLoader

# Stable Diffusionモデルの読み込み

sd_model = StableDiffusionModel()

sd_model.load_state_dict(torch.load('sd_model.pth'))

sd_model.eval()

# LoRAモデルの準備

lora_model = LoRAModel()

optimizer = optim.Adam(lora_model.parameters(), lr=0.001)

# ファインチューニングのデータセットとデータローダーの準備

dataset = CustomDataset(...)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# ファインチューニングの実行

for epoch in range(num_epochs):

for data in dataloader:

inputs, targets = data

optimizer.zero_grad()

outputs = lora_model(sd_model(inputs))

loss = compute_loss(outputs, targets) # 損失関数の計算

loss.backward()

optimizer.step()

# ファインチューニング後のモデルの保存

torch.save(lora_model.state_dict(), 'finetuned_lora_model.pth')このコードは、Stable DiffusionモデルとLoRAモデルを組み合わせて、ファインチューニングを行う基本的な手順を示している。

さらに詳細な応用に関し果て、”LoRA(ローラ)とは|今年注目の画像生成AI (Stable Diffusion) のファインチューニングを試してみた“、”【Stable Diffusion Web UI】追加学習モデルLoRAの使い方“、”LoRAって何?使い方とおすすめLoRAを解説。Stable Diffusion“も参照のこと。

Stable Diffusionの課題とその対応策について

Stable Diffusionは強力な画像生成および修復手法だが、いくつかの課題も存在している。以下にその課題と対応策について述べる。

1. 計算負荷の高さ:

課題: Stable Diffusionは計算量が非常に高い場合があり、特に高解像度の画像や大規模なデータセットを扱う場合、計算負荷が増大し、トレーニングや推論に時間がかかる可能性がある。

対応策: 高性能なハードウェアや分散トレーニングを使用して計算速度を向上させる。モデルの複雑さを削減するために、ネットワークのアーキテクチャを最適化する。軽量な代替手法やモデルを検討する。等が考えられる。

2. データの多様性への依存:

課題: Stable Diffusionの性能は、トレーニングに使用されるデータセットの多様性に依存している。特定のデータセットに偏った場合、モデルが一般化できない可能性がある。

対応策: 複数のデータソースからデータを収集し、トレーニングデータの多様性を確保する。データ拡張技術を使用して、トレーニングデータのバリエーションを増やす。ドメイン適応や“転移学習の概要とアルゴリズムおよび実装例について“でも述べている転移学習などの手法を使用して、他のドメインのデータにモデルを適応させる。等が考えられる。

3. 生成画像の品質の向上:

課題: Stable Diffusionによって生成される画像の品質には改善の余地があり、特に特定の条件下での不自然なアーティファクトや細部の欠落が問題となる場合がある。

対応策: モデルの損失関数を調整して、生成される画像の品質を改善する。モデルのアーキテクチャを調整して、より複雑な特徴を捉えられるようにする。画像生成のための別のアプローチや手法を検討し、組み合わせる。等が考えられる。

4. ノイズや欠損の処理の限界:

課題: Stable Diffusionはノイズや欠損の処理に効果的だが、特定の条件下では限界がある。例えば、大規模な欠損部分や極端なノイズの場合、十分な復元が困難な場合がある。

対応策: ノイズや欠損のパターンに応じて、適切な前処理やデータ拡張技術を適用する。ノイズや欠損のパターンをモデルに反映させるため、適切な損失関数やモデルアーキテクチャを使用する。等が考えられる。

参考情報と参考図書

画像情報処理の詳細に関しては”画像情報処理技術“を参照のこと。

参考図書としては”

“

“

“

コメント

[…] Stable DiffusionとLoRAの活用 […]

[…] Stable DiffusionとLoRAの活用 […]