ReAct(Reasoning and Acting)の概要

ReActは”プロンプトエンジニアリングの概要とその利用について“で述べているプロンプトエンジニアリングの手法の一つであり、”LangChainにおけるAgentとToolについて“で述べているLangChainのエージェントの活用のシーンでも利用されているものとなる。

「ReAct」は「Reasoning + Acting」からなる造語であり、ReAct のフレームワークでは以下のようなシーケンス処理が行われる。

- ステップ 1:タスクへの出力を生成するために必要な 行動(Act)とその 理由(Reason)を思考する。

- ステップ 2:この思考をもとに行動し、得られた結果から、再度次に必要な行動とその理由を思考する。

- ステップ 3:思考を繰り返し、ファイナルアンサーが生成できた時点で終了する。

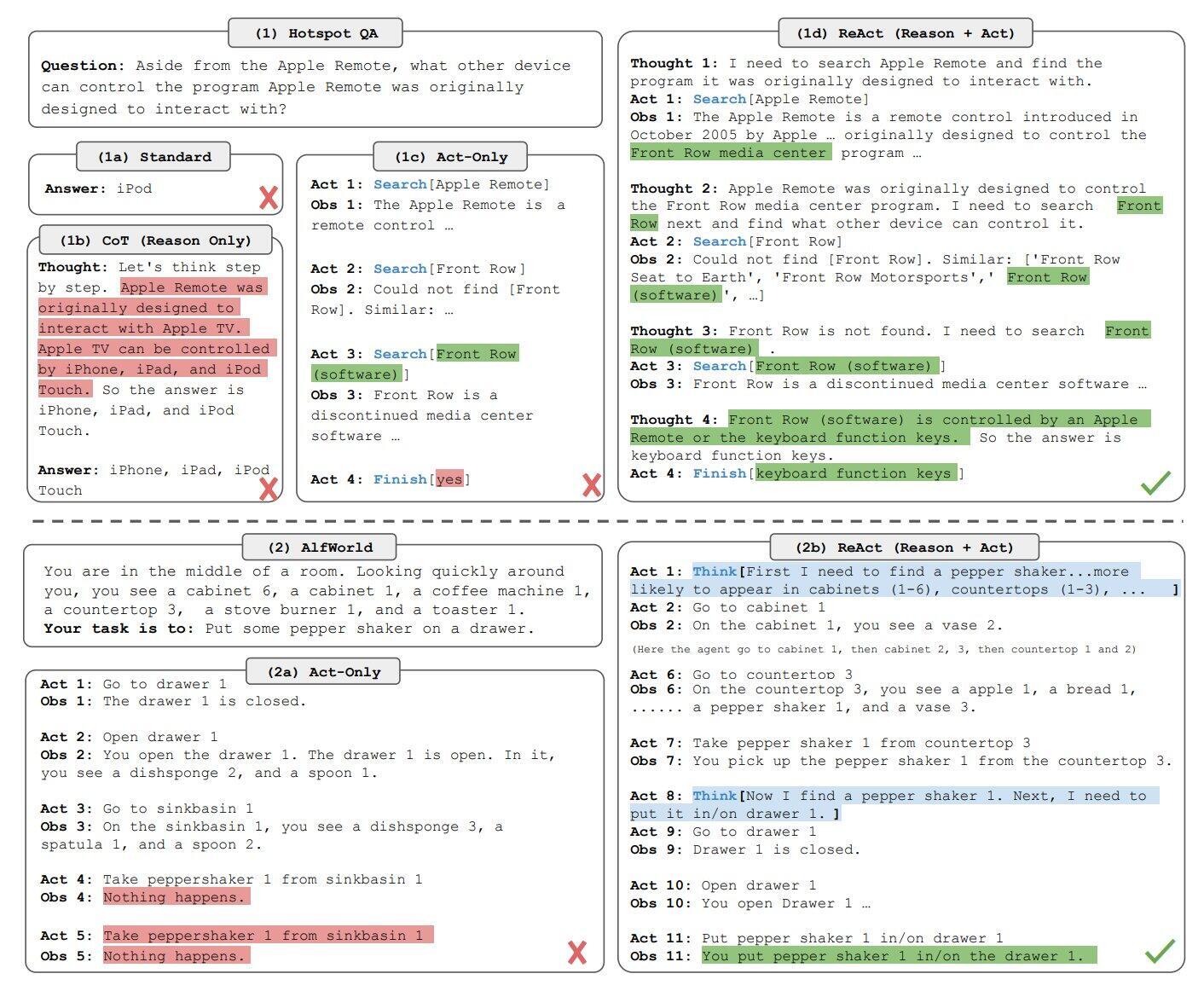

ReActに関しては”ReAct: Synergizing Reasoning and Acting in Language Models“という論文が報告されている。その中での動作の説明は下図のようになる。

図の右側の ReAct を見ると、Thought(Think)と Act、Obs(Observation)が繰り返され、最終的に正しい解答が得られるであろうことが読み取れる。なお、Act には次の 3 つの行動が設計されていて、モデルが行動を選択している。

- Search:対応するワードの Wikipedia ページが存在する場合はその最初の 5 文を返し、そうでない場合は類似するワードの上位 5 つを提案する

- Lookup:ワードを含む文章を返す(Ctrl+F 機能を模したもの)

- Finish:タスクを終了する

論文内では応答プロセスの具体例が提示されている。

- 質問:コロラド造山帯の東側が伸びている地域の標高範囲は?

- 思考1:コロラド造山を検索して、コロラド造山の東側が伸びている地域を見つけ、その標高範囲を求める必要がある。

- 行動1:[コロラド造山帯]を検索する。(Search)

- 観察1:コロラド造山帯は、コロラド州とその周辺地域でからなる造山帯である。

- 思考2:東部地区については言及されていない。だから、東部地区を調べる必要がある。

- 行動2:[eastern sector]を調べる。(Lookup)

- 観察2:(検索結果1件)東部はハイプレインズに広がっており、中央平原造山と呼ばれている。

- 思考3:コロラド造山帯の東部は、ハイプレインズに広がっている。だから、私は ハイプレインズを検索して、その標高域を調べる必要がある。

- 行動3:[ハイプレインズ]を検索する。(Search)

- 観察3:ハイプレインズは、2つの異なる陸地のうちの1つを指している。

- 思考4:ハイプレインズ(米国)を検索する必要がある。

- 行動4:[ハイプレインズ(アメリカ合衆国)]を検索する。(Search)

- 観察4:ハイプレインズは、グレートプレーンズの一部である。ハイプレインズは東から西へ、およそ1,800~7,000フィート(550~2,130m)の標高を持つ。

- 思考5:ハイプレインズは標高が約1,800から7,000フィートまで上昇するので、答えは1,800から7,000フィートとなる。

- 行動5:1,800~7,000ft。(Finish)これは、質問タスクに対して、思考 → 行動 → 結果の観察を繰り返し、最終的に答え 1,800 ~ 7,000ft を出力している。

ReAct によって、回答の精度はどの程度向上するのか、論文内での ReAct の精度評価は、いくつかのベンチマークデータセットでのタスクで行われている。 次の表は、HotpotQA と Fever という 2 つのデータセットに対する結果となる。

ここで、ReActと比較されているCoTはプロンプトエンジニアリングの応用事例の一つである”LLM の Chain-of-Thought プロンプティング“(多段階の推論)となる。

HotpotQA では、ReAct 単体では CoT にわずかに及ばない結果になっている。この点も含め、論文内では ReAct と CoT のふるまいの違いとそれぞれの問題点について触れられており、CoT は「無関係なテキストを生成する」ことが問題点で、ReAct は「前に行った思考や行動を繰り返してしまう」ケースがありそれが誤りにつながるとしている。

また、プロンプトのみの場合は ReAct + CoT-SC(SC:自己整合性) の組み合わせがよいこと、ファインチューニングを行う場合は ReAct がベストであることも述べられている。ファインチューニングに関してはパラメータ総数との関連があり、より大きなモデルの方が ReAct の効果が大きくなる。

ReAct(Reasoning and Acting)に関連するアルゴリズムについて

以下に、ReAct(Reasoning and Acting)に関連するアルゴリズムについて述べる。

1. マルコフ決定過程(Markov Decision Process, MDP): “マルコフ決定過程(MDP)の概要とアルゴリズム及び実装例について“で述べているマルコフ決定過程は、確率的な状態遷移と報酬を考慮に入れた行動選択問題をモデル化するための枠組みであり、エージェントが環境内で行動し、その結果として遷移する状態と報酬を受け取るというプロセスを表現するものとなる。ReActでは、このMDPを基に、推論した結果に基づいて最適な行動を決定するケースがある。

2. 強化学習(Reinforcement Learning): 強化学習は、エージェントが環境とのインタラクションを通じて学習する手法であり、エージェントは、行動の結果として得られる報酬を最大化するように学習し、最適な行動方策を獲得するものとなる。ReActでは、推論と統合して、強化学習アルゴリズムを用いて最適な行動を学習するケースがある。

3. ベイジアン推論(Bayesian Inference): ベイジアン推論は、確率モデルと観測データを用いて、未知の事象に関する推論を行う手法となる。ReActでは、ベイジアン推論を用いて推論の過程をモデル化し、不確実性を考慮した意思決定を行うケースがある。

4. マルチエージェントシステム(Multi-Agent Systems): マルチエージェントシステムは、複数のエージェントが互いに影響を及ぼしながら、共同で問題を解決するシステムとなる。ReActでは、複数のエージェントが推論と行動を組み合わせて協調し、集合的な知識や行動を生成するケースがある。

5. 深層強化学習(Deep Reinforcement Learning): 深層強化学習は、深層学習と強化学習を組み合わせた手法で、複雑な状態や行動空間を扱う際に有効なアプローチとなる。ReActでは、ディープニューラルネットワークを用いた強化学習アルゴリズムを活用し、推論と行動の統合を行うケースがある。

これらのアルゴリズムは、AIシステムが推論と行動を統合することで、より効果的で柔軟な意思決定を行い、様々な複雑な状況に適応する能力を高めることに寄与する。

ReAct(Reasoning and Acting)の適用事例について

以下に、ReActが適用される事例について述べる。

1. 自律ロボット: 自律ロボットは、環境を理解し、その理解に基づいて適切な行動を選択する必要がある。ReActのアプローチを用いることで、ロボットはセンサーデータや状況に基づいて推論を行い、最適な行動を取ることができ、例えば、自律運転車は周囲の交通状況や道路条件を推論し、適切な速度やルートを選択することが可能となる。

2. スマートシティの管理: スマートシティでは、様々なセンサーやデータが収集される。ReActを用いることで、これらのデータを分析し、交通誘導、エネルギー効率の最適化、公共サービスの改善などの意思決定に活用することが可能となり、例えば、混雑した地域への交通誘導や緊急事態への対応などができるようになる。

3. 医療診断: 医療診断では、患者の症状や検査結果から病気を推論し、適切な治療法を提案する必要がある。ReActを用いることで、医療AIは患者の情報を基に病気を推論し、最新の治療ガイドラインや患者の個別の特性に合わせた治療案を提示することが可能となる。

4. 金融取引の最適化: 金融取引においては、市場の変動や複雑な取引状況を考慮しながら最適な取引戦略を構築する必要がある。ReActを用いることで、市場データやトレンドを推論し、リスクとリターンをバランスさせた取引を行うことが可能となる。

5. ロボット製造と組み立て: 製造業では、部品や工程の最適化が重要です。ReActを用いることで、製造ライン上での部品の配置や製造工程の最適化を推論し、効率的な生産プロセスを確立することが可能となる。また、組み立てロボットは部品の配置や組み立て方法を推論し、より効率的に製品を組み立てることもできる。

6. ゲームAI: ゲームAIは、ゲーム内の状況を理解し、最適なプレイを行う必要がある。ReActを用いることで、ゲーム内の情報を推論し、プレイヤーに対する最適な反応や戦略を展開することが可能となる。

ReActのアプローチでは、推論と行動の統合により、AIシステムはより柔軟で効果的な意思決定を行い、複雑な状況に適応する能力を高めることが可能となる。

ReAct(Reasoning and Acting)の実装例について

ReAct(Reasoning and Acting)の実装例は、推論と行動の統合を実現するためのさまざまなアプローチがある。以下にいくつかの具体的な実装例について述べる。

1. マルコフ決定過程(MDP)と強化学習の統合: マルコフ決定過程(MDP)と強化学習を組み合わせることで、ReActの実装が可能となる。例えば、OpenAI Gymなどの強化学習環境を使用して、次のような手順で実装ができる。

状態(State)の定義:エージェントが行動する環境の状態を定義する。

行動(Action)の定義:エージェントが取れる行動のリストを定義する。

報酬(Reward)の設定:エージェントが行動した結果得られる報酬を設定する。

Q-Learningなどの強化学習アルゴリズムを使用して、MDPを解く:推論を用いて状態の推定と行動の選択を行う。

詳細は”マルコフ決定過程(MDP)と強化学習の統合したアルゴリズムと実装例について“も参照のこと。

2. ベイジアンネットワークを用いた推論と行動の統合: ベイジアンネットワークは、不確実性を表現し推論を行うための有力なツールとなる。ReActの一例として、次のような手順で実装することが可能となる。

ベイジアンネットワークの構築:状態や行動、報酬などをノードとして表現し、推論を行う。

ベイジアン推論を用いた意思決定:エージェントはベイジアンネットワークを使用して、最適な行動を決定する。

データとの統合:エージェントが行動し、環境から得られたデータを用いてベイジアンネットワークを更新する。

詳細は”ベイジアンネットワークを用いた推論と行動の統合によるReActの実装について“を参照のこと。

3. 深層強化学習(DRL)によるReAct: 深層強化学習(Deep Reinforcement Learning, DRL)は、深層学習を用いて状態や行動を表現し、強化学習を行う手法となる。ReActの実装例として、次の手順がある。

ニューラルネットワークを使用した状態の表現:状態を表現するためのニューラルネットワークを設計する。

強化学習の実行: ポリシーグラディエント法(Policy Gradient)などのDRLアルゴリズムを使用して行動の学習を行う。

推論と行動の統合:ニューラルネットワークを用いて推論し、その結果に基づいて行動を選択する。

“深層強化学習(DRL)によるReActの実装について“を参照のこと。

4. マルチエージェントシステムによるReAct: 複数のエージェントが協調して問題を解決する場合、マルチエージェントシステムを使用する。ReActをマルチエージェントに適用する場合、次のような手順が考えらる。

各エージェントが推論を行い、自身の行動を選択する。

エージェント間で情報を共有し、協調するためのメカニズムを実装する。

マルチエージェントシステム全体のパフォーマンスを評価し、最適な行動を学習する。

詳細は”マルチエージェントシステムによるReActの実装について“を参照のこと。

ReAct(Reasoning and Acting)の課題とその対応策について

以下に、ReAct(Reasoning and Acting)の課題と対応策について述べる。

1. 複雑な環境への適応:

課題: ReActシステムは、複雑な環境で推論と行動を統合する必要があり、環境の変化や不確実性に対処しながら、適切な行動を選択することは困難な課題となる。

対応策:強化学習や深層強化学習(DRL)を使用して、複雑な状態空間での意思決定を行う。モデル予測制御(Model Predictive Control, MPC)などの手法を用いて、将来の状態を予測し、最適な行動を決定したり、マルチエージェントシステムを活用して、複数のエージェントが協力し合って問題を解決するアプローチも考えられる。

2. サンプル効率の問題:

課題: 推論と行動の統合には多くのデータやサンプルが必要な場合があり、学習の効率が低下する。

対応策: データの再利用や効率的なサンプリング手法を使用して、学習の効率を向上させる。また、 軽量化や高速化技術を活用して、リアルタイムでの意思決定を可能にすることも考えられる。

3. データの不足とドメイン適応:

課題: 特定の環境やタスクにおいて、十分な量の訓練データが得られないことがあり、また、異なる環境やタスクへの適応が困難なこともある。

対応策: “転移学習の概要とアルゴリズムおよび実装例について“で述べている転移学習(Transfer Learning)を活用して、他のタスクや環境で学習した知識を活用したり、ドメイン適応手法を使用して、新しい環境やタスクに適応する能力を向上させることが考えられる。

4. 説明性と透明性の欠如:

課題:ReActシステムがどのように意思決定を行ったのか、その理由や根拠を説明することが難しい。

対応策: 可視化手法や解釈可能なAI技術を使用して、システムの意思決定プロセスを可視化し説明したり、透明性を高めるための規制やガバナンスの導入により、ReActシステムの運用を管理することが考えられる。

5. エンドツーエンドの最適化:

課題: ReActシステムをエンドツーエンドで最適化することが、ハードウェアやソフトウェアの両面で課題となる。

対応策: ハードウェアの性能向上や並列処理技術の活用により、リアルタイムでの推論と行動の統合を可能にしたり、ソフトウェアの最適化や高度なアルゴリズムの開発により、ReActシステムの性能を向上させることが考えられる。

参考情報と参考図書

機械学習による自動生成に関しては”機械学習による自動生成“に詳細を述べている。そちらも参照のこと。

参考図書としては“機械学習エンジニアのためのTransformer ―最先端の自然言語処理ライブラリによるモデル開発“

“

“

コメント

[…] ReAct(Reasoning and Acting)の概要とその実装例について […]

[…] ReAct(Reasoning and Acting)の概要とその実装例について […]

[…] 外部と干渉して言語モデルの限界を超える): Agentモデルでは主に”ReAct(Reasoning and Acting)の概要とその実装例について“で述べているReAct機能や、OpenAI Function Callingという手法を用いて […]

[…] ここでのreactは”ReAct(Reasoning and Acting)の概要とその実装例について“で述べている「Reasoning + Acting」を意味する。 […]