DNNにおけるエンコーダー/デコーダー

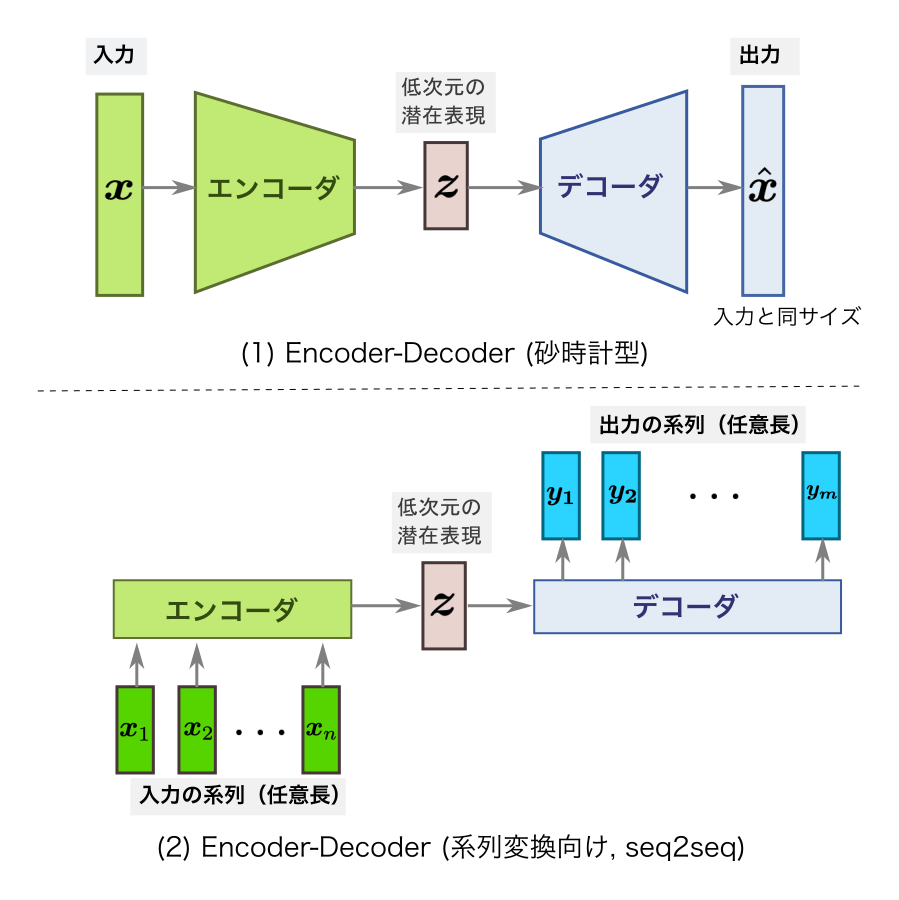

エンコーダー/デコーダーモデルは、深層学習における重要なアーキテクチャの1つで、特に、機械翻訳や音声認識などの”Seq2Seq(Sequence-to-Sequence)モデルの概要とアルゴリズム及び実装例について“でも述べているシーケンス対シーケンス(sequence-to-sequence)タスクで広く使用されているものとなる。このモデルは、入力シーケンスを固定長のベクトル表現にエンコードし、その後、その表現を使用してターゲットシーケンスを生成するためにデコードする構造となっている。

以下にエンコーダー/デコーダーモデルの基本的な構成と機能について述べる。

エンコーダー(Encoder): エンコーダーは、入力シーケンス(例: 文章、音声の波形)を処理して固定次元の表現に変換する部分 となる。この表現は、入力シーケンス全体の情報を包括したベクトル表現として考えることができ、エンコーダーは通常、”RNNの概要とアルゴリズム及び実装例について“で述べている再帰ニューラルネットワーク(RNN)、”LSTMの概要とアルゴリズム及び実装例について“で述べている長・短期記憶ネットワーク(LSTM)、”GRUの概要とアルゴリズム及び実装例について“で述べているでGRU、または最近では”Transformerモデルの概要とアルゴリズム及び実装例について“で述べているトランスフォーマー(Transformer)などのアーキテクチャで構成されている。

1. RNNベースのエンコーダー: 過去の情報を再帰的に(つまり、1つ前のステップの出力を次のステップの入力として)処理することで、シーケンス全体を理解する。

2. LSTM/GRUベースのエンコーダー: 長期的な依存関係を学習するために設計されたRNNのバリエーションで、シーケンスの中の重要な情報を保存する。

3. Transformerベースのエンコーダー: Self-Attentionと呼ばれる仕組みを使用し、シーケンス内の異なる位置の情報を効率的に取り扱う。このアーキテクチャは、長いシーケンスや大規模なデータセットで特に優れた性能を発揮している。

デコーダー(Decoder): デコーダーは、エンコーダーからの固定次元の表現を受け取り、ターゲットシーケンスを生成するためのモデルとなる。デコーダーは、生成したい出力シーケンスを1つずつトークン(単語や文字)として生成している。デコーダーも、RNN、LSTM、GRU、またはTransformerなどのアーキテクチャで構成される。

デコーダーの主な機能は次のようになる。

1. 開始トークン: ターゲットシーケンスの生成を開始するトークンを指定する。例えば、機械翻訳の場合は、開始トークンは通常、”<start>” とする。

2. 状態の初期化: エンコーダーからの最終的な隠れ状態やコンテキストベクトルなどの情報を受け取り、初期状態を設定する。

3. 次のトークンの予測: 現在の状態と直前に生成されたトークンを使用して、次のトークンを予測する。この予測は、ソフトマックス関数などの確率的な活性化関数を使用して行われることが一般的となる。

4. 終了トークンの生成: シーケンスの終了を示すトークン(例えば、”<end>”)が生成されるまで、次のトークンの予測と生成を続ける。

これらのプロセスを通じて、デコーダーは入力シーケンスの情報を保持しながら、ターゲットシーケンスを生成している。訓練時には、生成されたシーケンスと正解のシーケンスの間で損失を計算し、その損失を最小化するようにモデルを調整する。

エンコーダー/デコーダーモデルは、言語翻訳や会話モデリング、質問応答システム、要約、音声合成などの多くのタスクに適用されており、特に、トランスフォーマーなどの近年の発展により、長いシーケンスや大規模なデータセットに対する性能が向上した手法となる。

GNNにおけるエンコーダー/デコーダーモデルの概要

グラフニューラルネットワーク(Graph Neural Networks, GNN)におけるエンコーダーとデコーダーモデルは、グラフデータから特徴表現(エンベディング)を学習し、その表現を用いてグラフ上のさまざまなタスクを解決するための枠組みとなる。ここでは、GNNにおけるエンコーダーとデコーダーモデルの概要について述べる。

エンコーダーモデル(Encoder Model): GNNのエンコーダーモデルは、グラフ構造とノード/エッジの特徴を入力として受け取り、それらの情報からノードの表現(エンベディング)を生成する。一般的なエンコーダーモデルにはいくつかの種類があるが、その中でも代表的なものには次のようなものがある。

1. Graph Convolutional Networks (GCN): GCNは、隣接ノードの情報を利用してノードの表現を更新する畳み込みニューラルネットワークであり、典型的なGCNでは、次のような手順でノードの表現を更新している。

- 各ノードの隣接ノードから特徴を集約し、それを自身の特徴と結合する。

- 集約された特徴に対して、重み行列を用いて線形変換を行う。

- さらに活性化関数(例: ReLU)を適用して特徴を非線形にする。

2. GraphSAGE (Graph Sample and Aggregator): GraphSAGEは、ノードの特徴を集約するためにランダムウォークや隣接ノードのサンプリングを行うものとなる。これは次のような手順でノードの表現を更新している。

- 各ノードの周囲からサンプリングした隣接ノードの特徴を集約する。

- 集約された特徴に対して、重み行列を用いた線形変換を行う。

- 集約された特徴を元のノードの特徴と結合し、最終的な表現を得る。

デコーダーモデル(Decoder Model): GNNのデコーダーモデルは、エンコーダーモデルで学習されたグラフ中のノードの表現を用いて、特定のタスクを解決するものとなる。デコーダーモデルは、エンコーダーから得られたグラフ中のノード表現を入力として受け取り、それを用いてグラフ上のタスクを実行するアルゴリズムとなる。デコーダーモデルとしては以下の様なものがある。

1. ノード分類(Node Classification): ノード分類のタスクでは、各ノードが特定のクラスやカテゴリに属するかどうかを予測するものとなる。GNNのデコーダーモデルは、エンコーダーから得られたノードの表現を入力とし、ソフトマックス関数などを用いて各ノードのクラス確率を計算している。

2. リンク予測(Link Prediction): リンク予測のタスクでは、未知のエッジが存在する可能性を予測するものとなる。GNNのデコーダーモデルは、エンコーダーから得られたノードの表現を用いて、未知のエッジの存在確率を計算している。

3. グラフ生成(Graph Generation): グラフ生成のタスクでは、与えられた条件から新しいグラフを生成するものとなる。GNNのデコーダーモデルは、エンコーダーから得られたグラフ中のノード表現を用いて、新しいノードやエッジを生成するアルゴリズムを実装している。

エンコーダーモデルは、グラフデータからノードの表現を学習する部分であり、Graph Convolutional Networks(GCN)やGraphSAGEなどが一般的で、デコーダーモデルは、学習されたノードの表現を用いて特定のグラフ上のタスクを解決する部分であり、ノード分類、リンク予測、グラフ生成などがある。これらのモデルは、グラフデータの特徴を効果的に捉え、グラフ上の様々な問題を解決するために広く利用されている。

GNNにおけるエンコーダー/デコーダーモデルに関連するアルゴリズム

以下にGNNにおけるエンコーダーモデルとデコーダーモデルに関連する代表的なアルゴリズムについて述べる。

エンコーダーモデルのアルゴリズム:

1. Graph Convolutional Networks (GCN):

概要: 隣接ノードの情報を利用してノードの表現を更新する畳み込みニューラルネットワーク。GCNの詳細は”グラフ畳み込みニューラルネットワーク(Graph Convolutional Neural Networks, GCN)の概要とアルゴリズム及び実装例について“を参照のこと。

特徴: ノードの特徴を集約し、隣接ノードとの情報を組み合わせ、集約された特徴に対して、線形変換と活性化関数を適用する。

代表的な論文: “Semi-Supervised Classification with Graph Convolutional Networks” (Kipf & Welling, ICLR 2017)

2. GraphSAGE (Graph Sample and Aggregator):

概要: ノードの特徴を集約するためにランダムウォークや隣接ノードのサンプリングを行う。GraphSAGEの詳細は”GraphSAGEの概要とアルゴリズム及び実装例について“を参照のこと。特徴: ランダムウォークや隣接ノードから特徴をサンプリングし、集約し、集約された特徴を元のノードの特徴と結合し、最終的な表現を得る。

代表的な論文: “Inductive Representation Learning on Large Graphs” (Hamilton et al., NIPS 2017)

3. Gated Graph Neural Networks (GGNN):

概要: ノードの隣接情報を再帰的に更新するリカレントニューラルネットワーク。GCNNの詳細は”Gated Graph Neural Networks (GGNN)の概要とアルゴリズム及び実装例“を参照のこと。

特徴: ノードの特徴と隣接ノードからのメッセージを更新し、ゲート機構を用いて情報の流れを制御する。

代表的な論文: “Gated Graph Sequence Neural Networks” (Li et al., ICLR 2016)

デコーダーモデルのアルゴリズム:

1. Graph Convolutional Networks (GCN):

タスク: ノード分類、リンク予測、グラフ生成など

概要: エンコーダーモデルで学習されたエンベディングを用いて、特定のグラフタスクを解決する。

特徴: ノードのエンベディングを入力とし、ソフトマックス関数などを用いてタスクを実行する。

2. GraphSAGE (Graph Sample and Aggregator):

タスク: ノード分類、リンク予測、グラフ生成など

概要: エンコーダーモデルで学習されたエンベディングを用いて、特定のグラフタスクを解決する。

特徴: ノードのエンベディングを入力とし、適切なモデルを適用してタスクを実行する。

3. Graph Neural Networks (GNNs) with Attention Mechanisms:

タスク: ノード分類、リンク予測、グラフ生成など。

概要: エンコーダーモデルで学習されたエンベディングを、アテンション機構を用いて重要なノードに重点を置いて計算する。詳細は”GAT (Graph Attention Network)の概要とアルゴリズム及び実装例について“を参照のこと。

特徴: アテンション機構を用いて、エンベディングの重み付き和を計算し、タスクを実行する。

代表的な論文: “Graph Attention Networks” (Veličković et al., ICLR 2018)

GNNにおけるエンコーダー/デコーダーモデルの適用事例

GNNにおけるエンコーダーモデルとデコーダーモデルは、さまざまな実世界のグラフデータに適用され、さまざまなタスクに使用されている。以下にそれら適用事例について述べる。

1. ノード分類(Node Classification):

タスク: ソーシャルネットワークにおけるユーザーの属性(学生、教師、管理者など)の予測

エンコーダーモデル: Graph Convolutional Networks(GCN)やGraphSAGEなどを使用してノードの表現を学習

デコーダーモデル: 学習されたノードの表現を用いて、各ノードの属性を予測

2. リンク予測(Link Prediction):

タスク: ソーシャルネットワークにおいて、新しい友人関係の存在を予測

エンコーダーモデル: GraphSAGEやGCNなどを使用してノードの表現を学習

デコーダーモデル: 学習されたノードの表現を用いて、未知のエッジの存在確率を予測

3. グラフ生成(Graph Generation):

タスク: ケモインフォマティクスにおいて、新しい分子構造の生成

エンコーダーモデル: Graph Neural Networks(GNN)を使用して分子構造の表現を学習

デコーダーモデル: 学習された分子の表現を用いて、新しい分子の構造を生成

4. グラフクラスタリング(Graph Clustering):

タスク: ページランクアルゴリズムに基づくウェブページのクラスタリング

エンコーダーモデル: GNNを使用してウェブページの表現を学習

デコーダーモデル: 学習されたページの表現を用いて、クラスタリングアルゴリズムによりグループ化

5. トラフィック予測(Traffic Prediction):

タスク: 都市の交通フローを予測し、最適なルートを提案

エンコーダーモデル: GNNを使用して都市の交通ネットワークの表現を学習

デコーダーモデル: 学習された交通ネットワークの表現を用いて、交通量の予測と最適ルートの提案

6. グラフ異常検出(Graph Anomaly Detection):

タスク: ソーシャルネットワークにおいて、異常な行動パターンやネットワーク構造の検出

エンコーダーモデル: GNNを使用してノードやエッジの異常度を学習

デコーダーモデル: 学習された異常度を用いて、異常なパターンの検出と通知

GNNにおけるエンコーダー/デコーダーモデルの実装例

GNN(Graph Neural Networks)におけるエンコーダーモデルとデコーダーモデルの実装例について述べる。以下の例では、Pythonを使用して、主要なライブラリであるPyTorch Geometricを利用している。

エンコーダーモデルの実装例:

1. Graph Convolutional Networks (GCN):

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

class GCNEncoder(nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super(GCNEncoder, self).__init__()

self.conv1 = GCNConv(in_channels, hidden_channels)

self.conv2 = GCNConv(hidden_channels, out_channels)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

x = self.conv2(x, edge_index)

return x2. GraphSAGE:

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch_geometric.nn import SAGEConv

class GraphSAGEEncoder(nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super(GraphSAGEEncoder, self).__init__()

self.conv1 = SAGEConv(in_channels, hidden_channels)

self.conv2 = SAGEConv(hidden_channels, out_channels)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

x = self.conv2(x, edge_index)

return xデコーダーモデルの実装例:

1. ノード分類(Node Classification):

import torch

import torch.nn as nn

class NodeClassifier(nn.Module):

def __init__(self, in_channels, num_classes):

super(NodeClassifier, self).__init__()

self.fc = nn.Linear(in_channels, num_classes)

def forward(self, x):

x = self.fc(x)

return torch.log_softmax(x, dim=1)2. リンク予測(Link Prediction):

import torch

import torch.nn as nn

class LinkPredictor(nn.Module):

def __init__(self, in_channels):

super(LinkPredictor, self).__init__()

self.fc = nn.Linear(in_channels*2, 1)

def forward(self, x_i, x_j):

x = torch.cat([x_i, x_j], dim=1)

x = self.fc(x)

return torch.sigmoid(x)実装の例:

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

class GCNEncoder(nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels):

super(GCNEncoder, self).__init__()

self.conv1 = GCNConv(in_channels, hidden_channels)

self.conv2 = GCNConv(hidden_channels, out_channels)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

x = self.conv2(x, edge_index)

return x

class NodeClassifier(nn.Module):

def __init__(self, in_channels, num_classes):

super(NodeClassifier, self).__init__()

self.fc = nn.Linear(in_channels, num_classes)

def forward(self, x):

x = self.fc(x)

return torch.log_softmax(x, dim=1)

# グラフデータとモデルの定義

import torch_geometric.datasets as datasets

from torch_geometric.data import DataLoader

from torch_geometric.utils import train_test_split

from torch.optim import Adam

dataset = datasets.Planetoid(root='./data/Cora', name='Cora')

data = dataset[0]

data.train_mask = data.val_mask = data.test_mask = data.y = None

data = train_test_split(data, num_val=500, num_test=1000)

model = GCNEncoder(dataset.num_node_features, hidden_channels=16, out_channels=16)

classifier = NodeClassifier(in_channels=16, num_classes=dataset.num_classes)

# トレーニングループ

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model, classifier = model.to(device), classifier.to(device)

optimizer = Adam(list(model.parameters()) + list(classifier.parameters()), lr=0.01)

def train():

model.train()

classifier.train()

optimizer.zero_grad()

out = model(data.x.to(device), data.edge_index.to(device))

out = classifier(out)

loss = F.nll_loss(out[data.train_mask], data.y[data.train_mask])

loss.backward()

optimizer.step()

return loss.item()

for epoch in range(1, 201):

loss = train()

print(f'Epoch: {epoch:03d}, Loss: {loss:.4f}')

# テスト

def test():

model.eval()

classifier.eval()

out = model(data.x.to(device), data.edge_index.to(device))

out = classifier(out)

pred = out.argmax(dim=1)

test_correct = pred[data.test_mask] == data.y[data.test_mask]

test_acc = int(test_correct.sum()) / int(data.test_mask.sum())

return test_acc

test_acc = test()

print(f'Test Accuracy: {test_acc:.4f}')この例では、Coraデータセットを使用してノード分類のタスクを行っている。GCNをエンコーダーとして使用し、ノードの表現を学習し、その後NodeClassifierをデコーダーとして使用してノード分類を行い、データのロード、トレーニング、テストは、PyTorch Geometricの機能を使用して行われている。

GNNにおけるエンコーダー/デコーダーモデルの課題と対応策

以下にGNNにおけるエンコーダーモデルとデコーダーモデルの主な課題とそれに対する対応策について述べる。

1. 過学習(Overfitting):

課題: GNNは大規模なグラフデータセットに適用されることがあり、この場合、モデルが訓練データに過剰に適合し、汎化性能が低下する可能性がある。

対応策:

ドロップアウト(Dropout): 訓練中にランダムにノードやエッジの特徴を無効にすることで、過学習を防ぐ。

正則化(Regularization): L1やL2正則化を適用して、モデルの複雑さを制御する。

データ拡張(Data Augmentation): グラフのノードやエッジをランダムに変換することで、訓練データを増やし、汎化性能を向上させる。

2. グラフのサイズとスケーラビリティ:

課題: 大規模なグラフに対してエンコーダーモデルやデコーダーモデルを適用すると、計算コストが高くなる。

対応策:

ミニバッチ処理: グラフを小さなサブグラフに分割し、ミニバッチで処理することで、メモリ使用量を減らす。

サンプリング: ランダムにサンプリングすることで、大規模なグラフの部分的な表現を学習する。

3. 時間的な変化のモデリング:

課題: 動的なグラフにおいて、エンコーダーモデルが時間的な変化をうまく捉えられない場合がある。

対応策:

動的グラフモデル: 時間的な変化を考慮したモデルを使用する(例: Dynamic Graph Convolutional Networks)。

スナップショット学習: グラフを一定の時間間隔でスナップショットとして捉え、時系列データとして扱う。

4. ノードの追加や削除に対する頑健性:

課題: 動的なグラフにおいて、新しいノードが追加されたり、既存のノードが削除されると、エンコーダーモデルやデコーダーモデルが対応できない場合がある。

対応策:

オンライン学習(Online Learning): 新しいデータが到着するたびにモデルを更新し、追加や削除に対応する。

増量学習(Incremental Learning): 新しいデータをモデルに追加して学習することで、モデルを更新する。

5. グラフの特徴の不均衡:

課題: グラフデータにおいて、特定のノードやエッジの特徴が他のものと比較して不均衡な場合がある。

対応策:

クラスの重み付け(Class Weighting): 損失関数にクラスの重みを追加し、不均衡を補正する。

サンプリング手法の使用: レアなクラスをアンダーサンプリングやオーバーサンプリングすることで、データのバランスを取る。

6. 計算効率の向上:

課題: GNNは計算量が多く、大規模なグラフに対して時間がかかる場合がある。

対応策:

GPUの活用: GPUを使用して並列計算を行い、計算速度を向上させる。

モデルの最適化: モデルの構造を最適化し、冗長な計算を削減する。

参考情報と参考図書

グラフデータの詳細に関しては”グラフデータ処理アルゴリズムと機械学習/人工知能タスクへの応用“を参照のこと。また、ナレッジグラフに特化した詳細に関しては”知識情報処理技術“も参照のこと。さらに、深層学習全般に関しては”深層学習について“も参照のこと。

参考図書としては”グラフニューラルネットワーク ―PyTorchによる実装―“

“Graph Neural Networks: Foundations, Frontiers, and Applications“等がある。

コメント

[…] GNNにおけるエンコーダー/デコーダーモデルの概要とアルゴリズム及び実装例 […]